Пектиназа: чи варто допомагати організму засвоювати пектин із фруктів?

Краса зсередини: огляд нутрицевтиків для здоров’я шкіри, волосся і нігтів

Симбіотики нового покоління: як поєднання бактерій і волокон покращує здоров’я

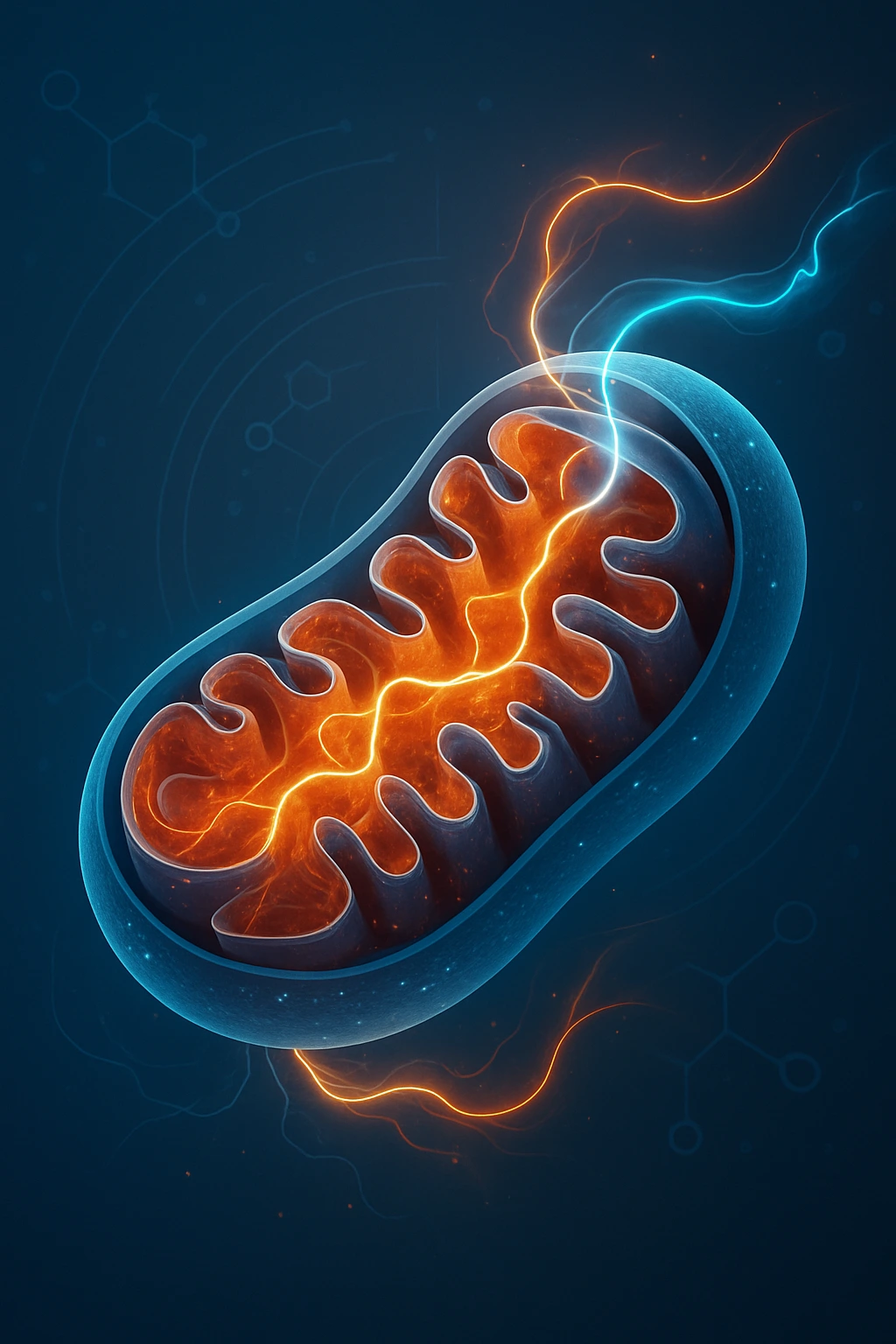

NAD⁺, NMN та NR: нутрицевтики для клітинної енергії та активного довголіття

Delivery-системи: як змінюються форми БАДів у 2025 році

Містер Блістер: Аналіз та тенденції в аптеках, медицині та фармацевтичній дистрибуції

Таніни та екстракти хурми: як природно регулювати жировий обмін і знижувати інтоксикацію

Вступ: нова роль відомого плоду Хурма давно відома як джерело вітамінів і мікроелементів, але завдяки…

Пектиназа: чи варто допомагати організму засвоювати пектин із фруктів?

Що таке пектин і як він працює в організмі? Пектин — це складний вуглевод, полісахарид,…

Функціональні волокна: як вони впливають на вагу, мікробіоту та рівень глюкози

Що таке функціональні волокна і чому вони важливі? Функціональні волокна — це харчові компоненти, які…

Антистрес-формули: що обирають у 2025 році

У 2025 році стан хронічного стресу став не винятком, а нормою. Війна, економічна нестабільність, інформаційне…

Краса зсередини: огляд нутрицевтиків для здоров’я шкіри, волосся і нігтів

Поняття «краса зсередини» перестало бути лише маркетинговим гаслом. Нині ми володіємо великою доказовою базою щодо…

Симбіотики нового покоління: як поєднання бактерій і волокон покращує здоров’я

Вступ: чому ми говоримо про симбіотики саме зараз? У 2025 році поняття «симбіотик» вийшло за…

Жіноче здоров’я після 40 років: сучасні підходи без гормональної терапії

Після 40 років в організмі жінки починається новий етап — перименопауза та менопауза, які супроводжуються…

NAD⁺, NMN та NR: нутрицевтики для клітинної енергії та активного довголіття

У сучасній медицині та нутрицевтиці зростає зацікавлення молекулами, що здатні впливати на глибинні механізми старіння,…

Delivery-системи: як змінюються форми БАДів у 2025 році

У світі нутрицевтики ефективність більше не залежить лише від активного інгредієнта. Delivery-системи — тобто способи…

Нутрицевтики для ментального здоров’я: від пробіотиків до шафрану

Пандемія, війна й економічна невизначеність різко підвищили рівень тривожних розладів та депресії в Україні. Попит…

Куркумін — «золоте» рішення для суглобів, шкіри й печінки: сучасний міждисциплінарний огляд

Спеція з яскравим кольором стала фігурою клінічної науки: понад 15 РКД та кілька метааналізів показали,…

Лікарські гриби у традиційній китайській медицині: науковий погляд і сучасне застосування

Протягом понад 5000 років традиційна китайська медицина формувала унікальне розуміння здоров’я як балансу між внутрішніми…